О чем говорят логи. Краулинговый бюджет

С помощью логов сервера мы можем извлекать важную информацию для больших и очень больших сайтов с более чем 1М страниц. Речь пойдет о так называемом выделенном поисковой системой лимитом запросов к конкретному сайту.

В зависимости от репутации сайта и его технических возможностей (и не только этого) формируются лимиты обращений робота к страницам и файлам сайта.

Лимиты поисковых систем могут изменяться в зависимости от текущего состояния проекта и их значение поможет определить существующие проблемы сайта – текущие и будущие.

Лично от меня (Климин Виктор)

Нижеописанное является моим мнением и оно построено на практическом опыте, а также из информации официальных источников и руководств. Нижеописанное также будет касаться, по умолчанию, поисковых систем Google и Яндекс.

Обращу внимание: использование методик из официальных источников и соблюдение спецификаций языка разметки – это самый верный способ формирования качественного сайта в глазах SEO на все времена и формирования грамотного «белошляпочного» SEO-специалиста. Помните о том, что публикуемая информация на форумах и блогах – это лишь следствие личного опыта автора статьи и не является единственным верным решением для всех направлений и типов контента (как и в данной статье).

Простая логика обхода и индексирования

Робот поисковой системы делает GET запрос к главной странице сайта и получает содержимое страницы, из этого содержимого также получает ссылки на другие страницы сайта. В следующем визите поисковый робот уже имея свою составленную базу ссылок производит запросы к найденным страницам и повторяет однотипную операцию снова и снова. Адреса страниц для последующего обхода поисковый робот получает не только из внутренних ссылок на сайте, а также из карты сайта (sitemap.xml) и внешних ссылок на сайт.

Начальный краулинговый бюджет

В период «рождения» сайта поисковая система определяет для него лимит запросов, которые индексирующий робот может делать для индексирования содержимого сайта. Исходя из «репутации» сайта ему назначается определенный лимит запросов. Далее поисковый робот производит запросы к сайту в отведенном для него кол-ве запросов и получает разнообразную информацию: страницы, изображения, файлы стилей, js и т.д.

Дальнейшее распределение краулингового бюджета завит от самого ресурса, его развития и популярности. Соответственно чем интереснее ресурс, чем чаще его цитируют пользователи на других сайтах, уникальнее и на котором периодически появляется интересная информация для пользователей, а также больше может выделяться бюджет для ежедневного обхода сайта.

Динамическое изменение краулингового бюджета

Чем больше сайт, тем более востребован факт ведения статистических данных обхода сайта роботами поисковых систем. Исходя из ежедневных данных в процессе работы Вы увидите, как меняется краулинговый бюджет изо дня в день в зависимости от зафиксированных Вами факторов в работе:

- Частота отдачи 500-х и 404-х кодов ответа.

- Частота обновления контента на странице.

- Уникальность контента.

- Скорость обработки данных сервером и выдача результата клиенту.

- Цитируемость страниц сайта в просторах Интернета и т.д.

На основе данных по статистике делайте выводы об успешности сайта в глазах поисковых систем. По простой логике: чем больше запросов делает поисковая система к сайту, тем (по мнению поисковой системы) сайт полезнее и на него стоит уделить внимание и ресурсы.

Исходя из вышеописанного логичный вывод будет в противоположном случае - поисковая система уменьшает краулинговый бюджет потому что:

- сервер не справляется с большим кол-вом запросов и перестает отвечать,

- сервер не корректно обрабатывает запросы и возвращает 500-ые коды ответа,

- контент сайта не уникален и малоинтересен пользователям,

- содержимое страницы изменяется редко.

Краулинговый бюджет у каждой поисковой системы свой и динамику изменения бюджета можно наблюдать также разную, даже кардинально измененную. Например, вполне возможна ситуация, когда Яндекс производит в сутки по 200К запросов в то время, как Google будет делать всего 5К запросов.

Исходя из этого стоит оценивать время, потраченное на индексирование большого сайта. Если на сайте более 30М страниц и все они уникальны и полезны, то их индексация займет немало времени:

- Яндекс просканирует сайт за 150 суток.

- Google просканирует сайт за 6.000 суток (16 лет)!

Если говорить о реальных ситуациях, то эти цифры могут быть как гораздо меньше, так и чуть больше. Все зависит от результатов работы сайта, его репутации и популярности. Те, кто вели ститистику логов сервера,те наблюдали скачки бюджета и замечали, что в самом «начале жизни сайта» этот лимит запросов либо сильно скачет, либо сначала завышен и потом падает, либо в лучшем исходе лимит постепенно повышается – что символизируется успешно развивающийся ресурс и «здоровье» сайта.

Советы для экономии краулингового бюджета

При проектировании сайта и его запуском (или перед открытием сайта для поисковых роботов) следует учитывать факторы:

- Не следует указывать в тегах ссылок (тег A) адреса на ненужные страницы типа HTML форм для модальных окон. Это влечет за собой уменьшение краулингового бюджета на нужные страницы, появление ненужных страниц в SERP и нарушение логики структуры проекта в глазах поисковой системы.

- Использовать ссылки на страницы, которые возвращают 200-й код ответа (за исключением контента, доступного зарегистрированным пользователям). Бывает, что на сайте указывается ссылка на страницу, при запросе которой робот получает 301-й код ответа и на этом визит прекращается, хотя мог бы пройти с 200-м кодом и получением контента страницы.

- Запрещайте для индексирования страницы сайта, которые не должны участвовать в органическом поиске. Тем самым вы сохраняете определенное кол-во запросов к нужным страницам сайта. Варианты корректного запрета к индексированию страницы:

- Ссылке, которая ведет на нежелательную страницу необходимо добавить атрибут со значением "rel=nofollow". Даем указание роботу не следовать по ссылке.

- Запрещаем индексирование страницы в файле /robots.txt

- На не желательной странице в HEAD добавляем указания для роботов:

<meta name="robots" content="noindex" />. Еще одно упоминание роботам, что содержимое данной страницы не следует индексировать.

- Составьте карту сайта для роботов sitemap.xml, в котором укажите только необходимые для индексирования страницы. Также убедитесь, что все страницы из карты сайта возвращают 200-й код ответа и «не зависают». В завершении пропишите в файле /robots.txt ссылку на карту сайта используя конструкцию:

Sitemap: https://site.ru/sitemap.xml - Оптимизируйте скорость загрузки страницы. У индексирующего робота есть также лимит времени ожидания, который ограничивает время загрузки страницы. Тем самым если за определенный промежуток времени страница не была полностью загружена роботом, то он может прекратить сканирование страницы и уйти не получив результата или получив не корректные данные. Как следствие этого в поисковую базу могут попасть либо не корректные данные либо страниц для сканирования в сутки будет меньше чем хотелось бы. Все данные по скорости загрузки и идеях на ускорение загрузки можно увидеть, воспользовавшись сервисом «WebPageTest»

Официальные источники данных

Для того, чтобы отслеживать краулинговый бюджет своего сайта существует несколько основных источников данных в зоне «Вебмастер»:

- Google (Сканирование - Статистика сканирования)

- Яндекс (Индексирование - Статистика обхода)

- Mail.ru (Сканирование - Статистика)

- Логи сервера (точнее быть не может)

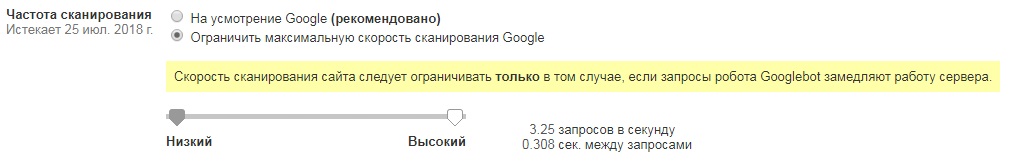

Ручная регулировка краулингового бюджета у Google

У Google есть возможность ограничения кол-ва запросов к сайту путем установки лимита максимума в Search Console . Данной возможностью вы можете воспользоваться в разделе «Настройки сайта» (справа иконка шестеренки в кабинете вебмастера).

Увеличить кол-во минимальных запросов не получится, но есть возможность ограничения запросов от робота Google к сайту.

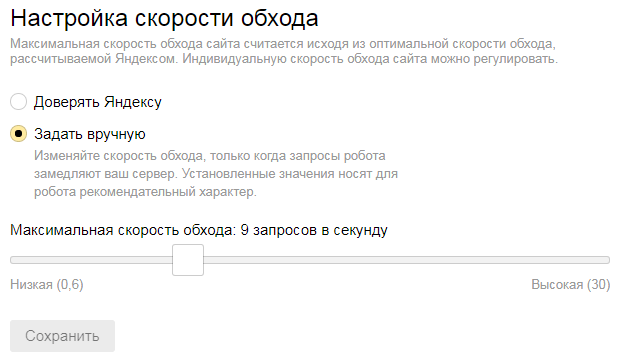

Ручная регулировка краулингового бюджета у Яндекса

Не так давно у Яндекса появился инструмент для вебмастеров под названием «Скорость обхода» (Индексирование - Скорость обхода). При помощи данной инструмента вебмастер может напрямую дать рекомендацию поисковому роботу Яндекса о повышении или понижении лимита запросов к сайту.

Задавая вручную скорость обхода будьте внимательны и помните, что в случае малых мощностей сервера это может существенно повлиять на его работоспособность, пусть даже на один день.

Скорость обхода следует увеличивать постепенно и смотреть по логам не увеличилось ли кол-во возвращаемых 500-х кодов, а также не забывать посматривать скорость ответа страниц (может быть и повышение времени загрузки страницы, что приводит к задержкам и «зависаниям» и как следствие ухода посетителя не дождавшись загрузки страницы).

Не смотря на рекомендации вебмастера поисковый робот Яндекса может и не производить такого кол-ва запросов к серверу. Например из скрина выше видим, что задано значение «9 запросов в секунду», что якобы равняется около 777К запросам в сутки. В реальности же кол-во запросов может быть и 70К и 200К.

Поисковые системы сами определяют, какое кол-во запросов «заслуживает сайт» и можно ли их повышать – для поисковых систем всегда было есть и будет первой целью это интересы пользователей и чтобы их нагрузка не помешала пользователям просматривать сайт.